Computer snapt hoe 3D-joysticks werken door ernaar te kijken

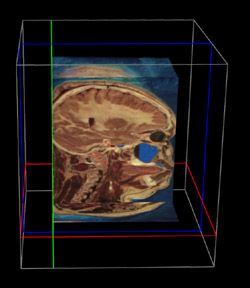

Een controller om een 3D-hersenscan te bekijken en doorsnedes te maken

Een joystick of een muis zijn prima middelen om je muispijl of pacman op een 2D-beeldscherm te bewegen. Maar wat als je allerlei handelingen moet gaan uitvoeren in een virtuele 3D-ruimte? Wat voor ‘controller’ gebruik je dan? TU/e-promovendus ir. Arjen van Rhijn ontwikkelde een techniek waarmee het mogelijk is om snel ‘controllers’ van elke gewenste vorm en functionaliteit te maken. Die ook nog eens vanzelf door de computer geanalyseerd en begrepen worden, gewoon door ‘m ernaar te laten kijken.

Stel: je bent hersenchirurg. En je wilt even door de 3D-hersenscan van een van je patiënten lopen, om te bekijken waar die tumor precies zit. Dan wil je de 3D-

afbeelding van het hoofd van je patiënt op alle mogelijke manieren kunnen bewegen en kantelen, zodat je het van alle kanten kunt bekijken. Dat vergt zes vrijheidsgraden: bewegen langs de x-, y- en z-as, en roteren om die assen. Maar voor een chirurg is het ook gemakkelijk als je her en der doorsnedes van het hoofd kunt maken, om de zaak nader te bestuderen. En daartoe moet je een doorsnedevlak in de 3D-afbeelding kunnen plaatsen. Grote vraag: hoe breng je als chirurg al die informatie over aan de computer, die je de gewenste positie, kanteling en doorsnede van het hoofd moet laten zien?

Arjen van Rhijn werkte ruim vier jaar bij het Centrum voor Wiskunde en Informatica in Amsterdam aan een systeem om dergelijke taken uit te voeren. Zijn uitgangspunt was daarbij dat de controller zoveel mogelijk intuïtief moet zijn. Met andere woorden: de beweging die het te manipuleren object in de virtuele ruimte (VR) maakt, maak je ook in de echte wereld, met je controller. In de meeste gevallen heeft het de voorkeur dat de controller dezelfde vorm heeft als het object in de VR, zodat je met je handen voelt wat je manipuleert. Bovendien moet elke VR-taak een eigen, specifieke controller krijgen, wat Van Rhijn betreft. Niet alleen qua vorm, maar ook qua functionaliteit. Een generieke controller die je op veel verschillende taken toepast leidt meestal tot compromissen in intuïtief bedieningsgemak.

De onderzoeker ontwikkelde een ‘optisch trackingsysteem’ dat nieuwe controllers vanzelf herkent. Het werkt met twee of meer camera’s die alleen infrarood licht waarnemen. Elk willekeurig object kan tot controller omgetoverd worden, door er voldoende stickertjes op te plakken die infrarood licht weerkaatsen. Je laat het object vervolgens rustig van alle kanten zien aan de camera’s, de computer maakt op basis van het stippenpatroon een model in zijn geheugen, en klaar is je controller. De computer kan daarna, met de kennis van dit model en op basis van de beelden van de twee camera’s, bepalen waar de controller is en hoe die gekanteld is. En daarmee dus bepalen hoe de gebruiker van de controller wil dat het object in de virtuele ruimte beweegt.

Een controller om een poppetje in een 3D-omgeving te bewegen

Occlusie

Klinkt simpel, maar er komt een hoop wiskunde en software-ontwikkeling bij kijken voordat het enigszins foutloos loopt. Een probleem was bijvoorbeeld

‘occlusie’. Het kan goed voorkomen dat de gebruiker zijn hand voor enkele van de reflecterende stickers houdt. Toch moet de computer dan nog het object herkennen. De oplossing die Van Rhijn hiervoor gebruikte, was de computer niet te laten zoeken naar alle punten, maar naar kleinere deelverzamelingen punten die voldoende zijn om plaats en positie te bepalen.

De oio ging nog een stapje verder. Want met de tot nu toe geschetste controller kun je alleen bewegen en roteren. Maar het was de bedoeling dat er nog veel meer acties met de controller doorgegeven kunnen worden naar de virtuele ruimte. Van Rhijn creëerde daarom de mogelijkheid om zaken als draaiknoppen en scharniertjes vast te klikken op de controller. Ook die worden voorzien van een reflecterende sticker, zodat de computer kan waarnemen of de gebruiker ze beweegt. En ook hiervoor geldt: het is niet nodig handmatig een model in te voeren in de computer. De ontwikkelde software zit zo in elkaar dat het volstaat om aan de camera’s te laten zien hoe de verschillende onderdelen bewegen, en de computer maakt er zelf een model van, wat het ook is.

Sommige van de door Van Rhijn ontwikkelde technieken behoeven nog ontwikkelwerk, andere zijn gebruiksklaar, en worden al toegepast door het CWI. Zijn copromotor gaat de nieuwe kennis op de markt brengen via zijn bedrijf Personal Space Technologies, waar dr.ir. Van Rhijn binnenkort ook op de loonlijst staat./.

Arjen van Rhijn verdedigt zijn proefschrift op donderdag 18 januari om 16.00 uur in zaal 4 van het Auditorium.